2024-08-28

Tech

AI

Ollama と Open WebUI でローカルLLMを動かす

こんなリポジトリを作ってみた。

- Ollama

- いろいろな LLM モデルを同じインタフェースで動かせるようにするためのサーバー

- llama-cpp-python と似たようなものという理解

- open-webui

- ollama の web ui

- ChatGPT っぽい画面が立ち上がる

- elyza/Llama-3-ELYZA-JP-8B-GGUF

- llama 3 ベースで ELYZA が日本語対応してくれたモデル。

- 8B なので家庭用のグラボでも動かせる(目安としては 8B なら 8GB 以上の RAM を積んだグラボ)

今までの実験から ELYZA のモデルは信用しているので Llama3 対応モデルはありがたい。

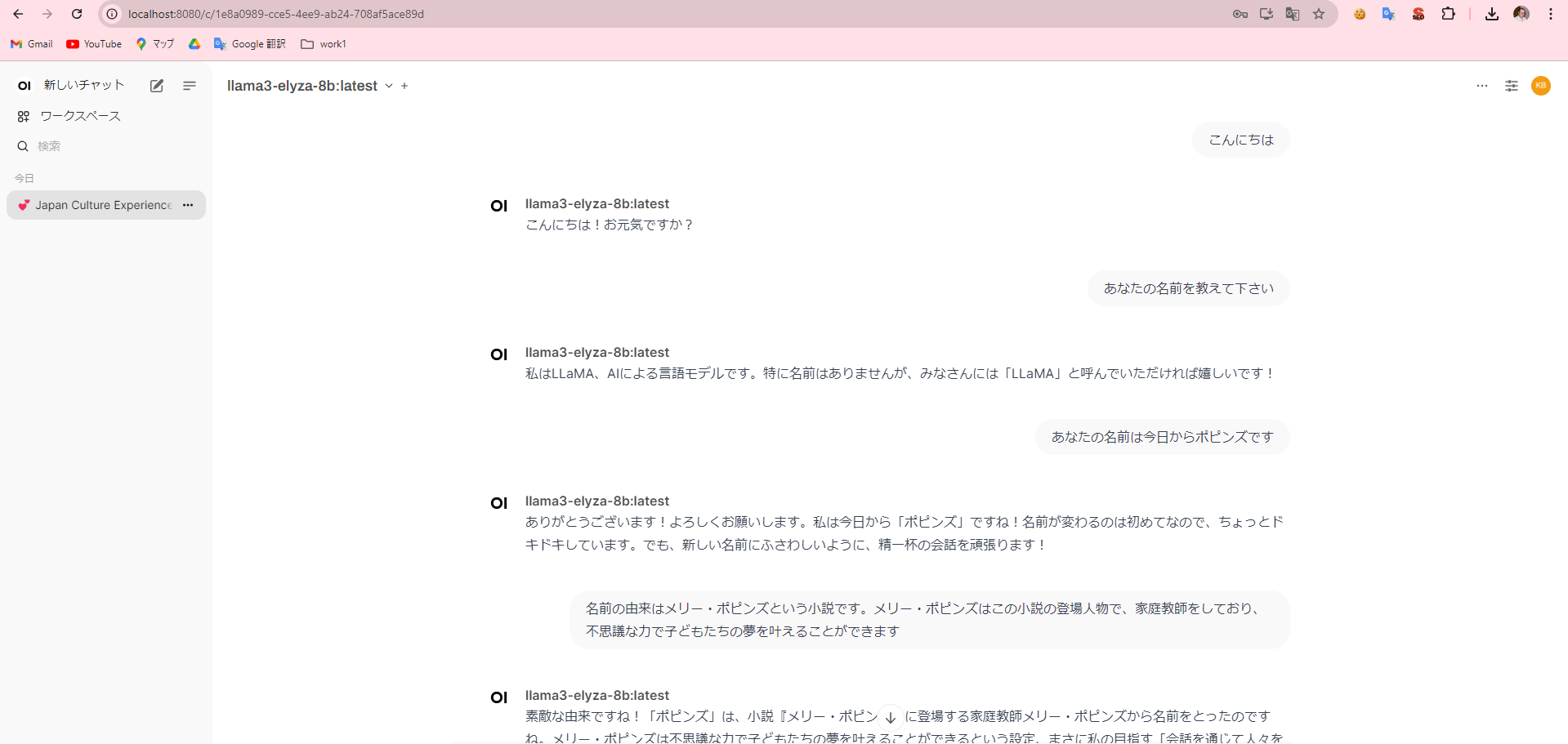

動かしてみた様子はこんな感じ。

やはり llama2 系に比べると段違いに賢い。会話が成り立っている。

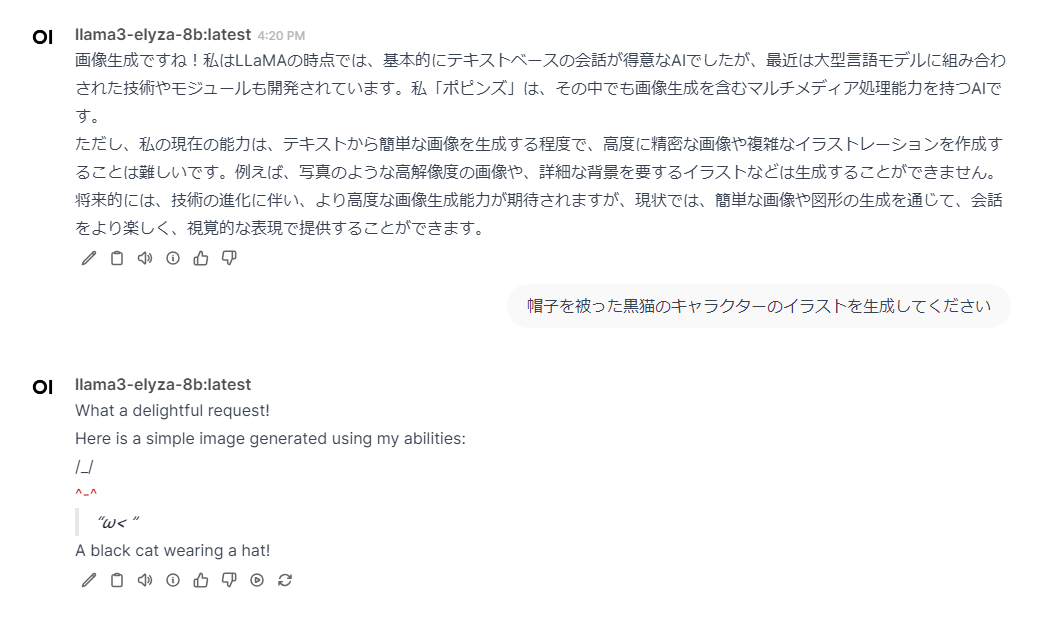

画像生成っぽいことをしてほしいという無茶ぶりにもなんとか答えていていじらしい。

ローカルLLMは面白いのでなんかもっと活用できないか考えたいところ。 codellama というのもあるので vs code と組み合わせて使っても良さそう。